Como parte de nuestra agenda permanente de estudios de validez y confiabilidad, MIDE UC presenta un análisis sobre la convergencia de los resultados de sus pruebas SEPA en relación con SIMCE, a nivel de establecimientos educativos. Este estudio muestra correlaciones elevadas en todos los niveles medidos por ambas pruebas durante los últimos tres años, aportando evidencia de validez convergente en estas mediciones basadas en el currículum nacional.

Mediante una metodología correlacional, se analizaron datos de establecimientos que participaron en ambas evaluaciones, lo que permitió confirmar que los ordenamientos generados por SEPA y SIMCE resultan notablemente similares. Esta consistencia fortalece la confianza en el uso pedagógico de SEPA, especialmente para monitorear el progreso individual de los estudiantes y orientar decisiones educativas en todos los niveles.

¿Por qué es importante estudiar la convergencia entre SEPA y SIMCE?

Cuando dos pruebas miden aprendizajes basados en el mismo currículum, es natural preguntarse: ¿Entregan resultados similares?

Esta duda, frecuente entre docentes y equipos directivos que aplican nuestras pruebas SEPA, no solo nos parece válida, sino que debemos como desarrolladores responderla. SEPA y SIMCE son mediciones basadas en el currículum chileno, por lo tanto, deberían realizar ordenamientos similares entre establecimientos para los cursos que miden ambas pruebas. Esto sería evidencia de validez convergente de acuerdo con los estándares que nos rigen (AERA, APA & NCME, 2018; Abarzúa & Contreras, 2019).

Luego del paso de la pandemia, SIMCE ha retomado la publicación de resultados por establecimiento (identificados mediante RBD), lo que nos permite contar con los datos necesarios para realizar esta comparación entre las dos pruebas.

SEPA vs. SIMCE: objetivos y diseños diferentes, para mediciones con una base común

Aunque ambas pruebas son mediciones basadas en el currículum nacional, difieren en sus usos intencionados y metodologías para ello. A continuación, se sintetizan sus principales diferencias:

¿Para qué se usan?

SIMCE evalúa los resultados de aprendizaje poniendo foco en observar el logro de aprendizaje de los estudiantes en cada curso medido a través de un puntaje estándar y niveles de logro. Es obligatoria y entrega resultados a nivel de escuela y curso, sin proporcionar información sobre el logro de cada estudiante. Posibilita comparaciones entre escuelas y entre distintas generaciones o cohortes que rinden las pruebas en los niveles educativos evaluados.

SEPA monitorea los aprendizajes en cada curso evaluado y entrega resultados detallados para cada estudiante, midiendo su progreso individual a través del tiempo. Su uso principal es establecer cuánto progresa cada estudiante entre un grado y el siguiente y así describir su trayectoria de aprendizaje. A diferencia de SIMCE, los puntajes de SEPA se pueden comparar entre los distintos grados educativos que son evaluados en el establecimiento. Así es posible saber, por ejemplo, si los estudiantes han progresado más entre 3° y 4° básico que entre 6° y 7° de cada estudiante año a año. Esta información puede ser analizada tanto a nivel individual como agregado a nivel de aulas, grados y escuelas.

¿Cómo se aplican?

Ambas mediciones son aplicadas en lápiz y papel y una vez que ha finalizado el año escolar. SIMCE usa un diseño de bloques rotados (cada estudiante responde una parte de la prueba), lo que permite precisión a nivel de grupos (cursos y establecimientos educativos). SEPA, por su parte, aplica una prueba única completa a todos los estudiantes, lo que permite mayor precisión del resultado a nivel individual, posibilitando retroalimentar a cada estudiante. Aplicar una prueba única supone una selección cuidadosa de los ítems que componen esta prueba, para obtener una muestra representativa de los conocimientos curriculares que se quiere medir.

¿Cuál es su cobertura?

SIMCE se aplica solo en ciertos niveles cada año, censalmente. No todos los niveles se aplican todos los años. En cambio, SEPA se aplica desde 1° básico hasta III° medio, en las asignaturas de lenguaje y matemática en establecimientos que deciden participar de esta medición a lo largo del país, resultando en más de 30.000 estudiantes al año distribuidos a lo largo del territorio nacional.

Cómo se estudió la convergencia

Para examinar si los resultados de ambas mediciones convergen, se realizó un análisis correlacional sobre los datos disponibles a nivel de establecimiento educacional, trabajando con el resultado promedio por RBD. Para asegurar robustez del resultado, se consideraron establecimientos con al menos 10 estudiantes participantes en ambas evaluaciones.

El número de establecimientos educacionales disponibles para este análisis se detalla a continuación:

Tabla 1. Número de establecimientos incluido en este análisis, por nivel educativo y año para los sectores de Lenguaje y Matemática.

| Lenguaje | Matemática |

|---|

| Año | Nivel | N colegios | Año | Nivel | N colegios |

|---|---|---|---|---|---|

| 2022 | 4° Básico | 31 | 2022 | 4° Básico | 30 |

| 2022 | II° Medio | 41 | 2022 | II° Medio | 42 |

| 2023 | 4° Básico | 36 | 2023 | 4° Básico | 35 |

| 2023 | II° Medio | 39 | 2023 | II° Medio | 40 |

| 2024 | 4° Básico | 28 | 2024 | 4° Básico | 27 |

| 2024 | 6° Básico | 29 | 2024 | 6° Básico | 28 |

| 2024 | II° Medio | 47 | 2024 | II° Medio | 49 |

Dado que los resultados de ambas evaluaciones son comparables entre años (se encuentran en una misma métrica mediante procedimientos de equiparación), las correlaciones se realizaron para cada sector y nivel de enseñanza, acumulando la información de los tres últimos años.

Resultados: convergencia SEPA – SIMCE

Los análisis realizados resultaron en correlaciones elevadas entre los resultados SEPA y SIMCE en todos los grados estudiados, para ambas áreas evaluadas, con los siguientes coeficientes, todos ellos estadísticamente significativos:

Tabla 2. Coeficientes de correlación, por nivel educativo, para los sectores de Lenguaje y Matemática.

| Lenguaje |

|---|

| Nivel | Coeficiente de Correlación | Valor p |

|---|---|---|

| 4° Básico | 0,87 | 0,00 |

| 6° Básico | 0,92 | 0,00 |

| II° Medio | 0,90 | 0,00 |

| Matemática |

|---|

| Nivel | Coeficiente de Correlación | Valor p |

|---|---|---|

| 4° Básico | 0,93 | 0,00 |

| 6° Básico | 0,97 | 0,00 |

| II° Medio | 0,94 | 0,00 |

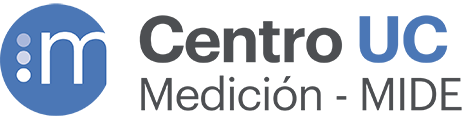

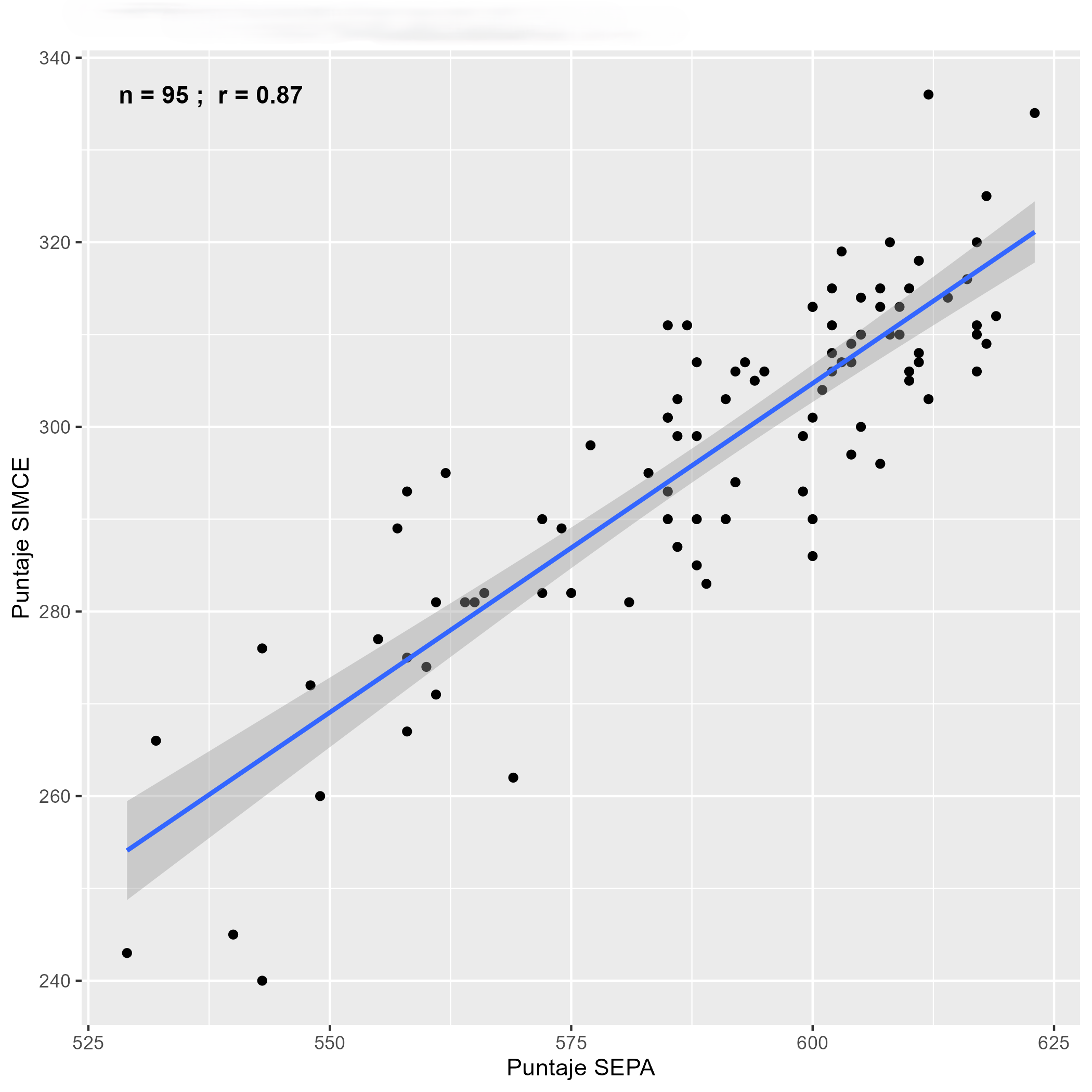

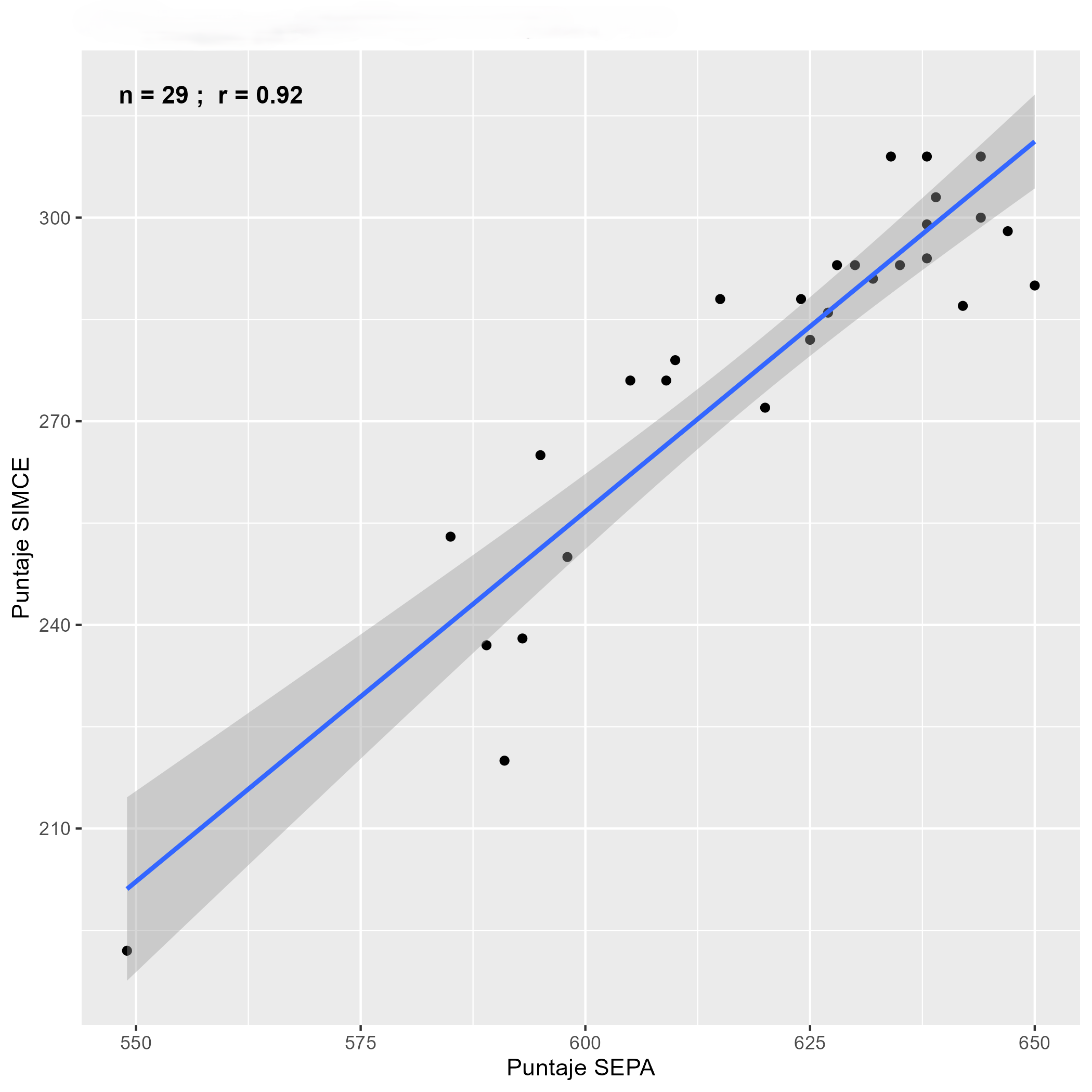

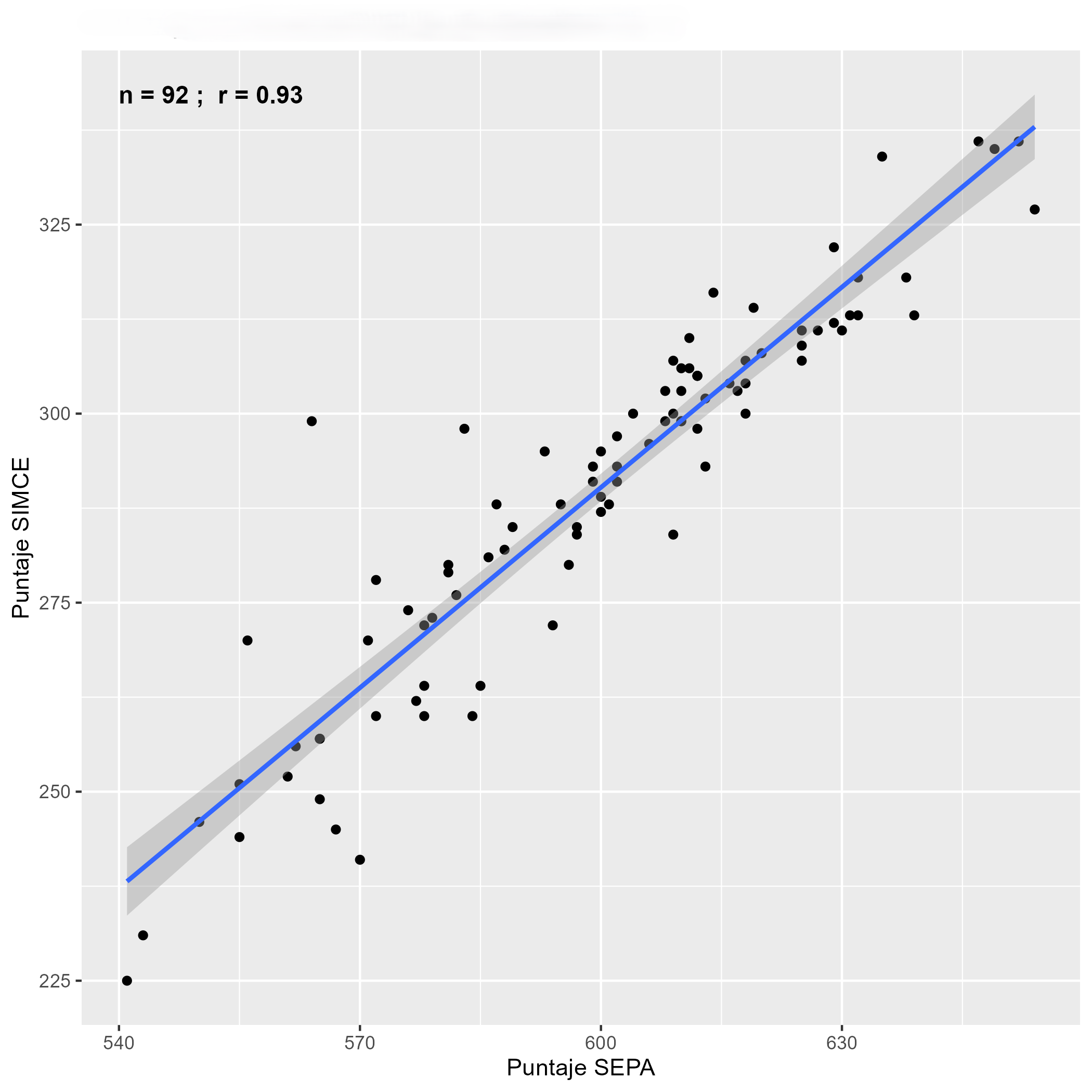

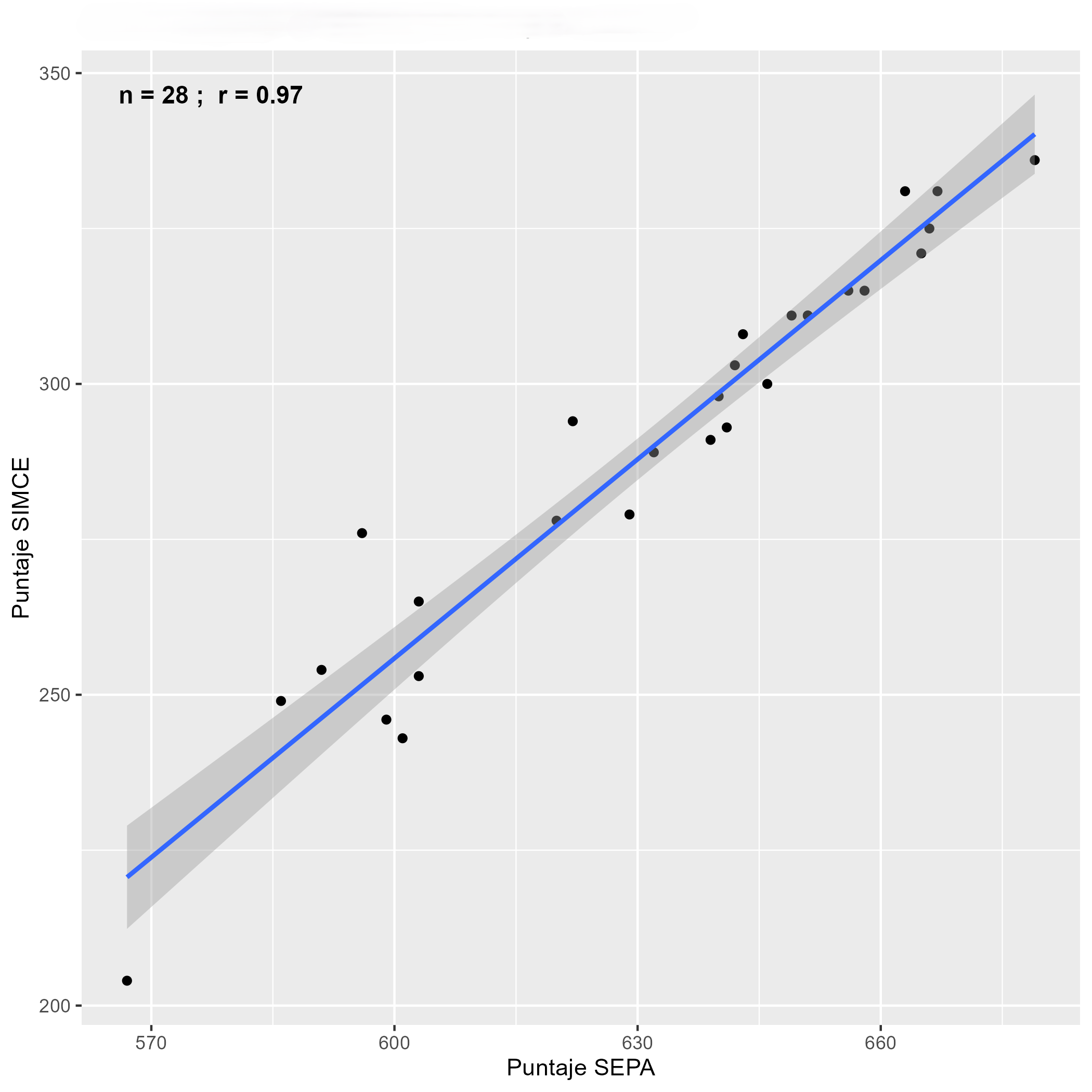

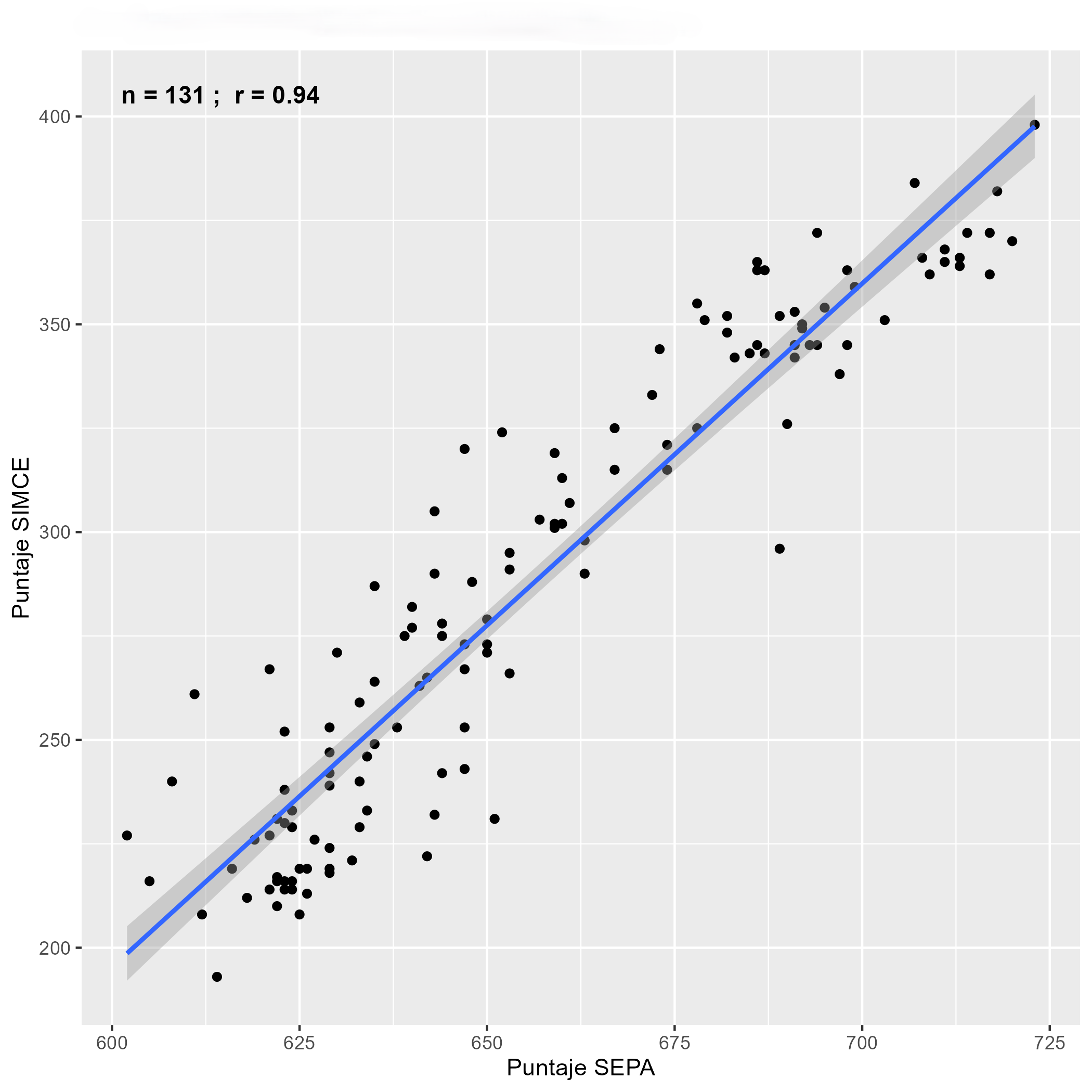

Gráficamente, las correlaciones muestran la alta similitud del ordenamiento de escuelas en ambos sectores (Figuras 1 y 2).

Figura 1. Correlaciones pruebas de Lectura para los grados estudiados.

| 4° Básico | 6° Básico | II° Medio |

|---|---|---|

|  |  |

Figura 2. Correlaciones pruebas de Matemática para los grados estudiados.

| 4° Básico | 6° Básico | II° Medio |

|---|---|---|

|  |  |

Síntesis y conclusiones

Los resultados aquí presentados entregan base suficiente para afirmar que existe alta convergencia, a nivel de establecimientos, en los resultados de ambas mediciones. Esto es evidencia importante de validez en el caso de nuestras pruebas, las que, como dijimos más arriba, realizan una selección de contenidos a evaluar año a año buscando describir correctamente el aprendizaje de elementos claves del currículum a diferencia de SIMCE, que por diseño puede administrar un número mayor de ítems para representar el currículum al contar con un diseño de bloques rotados donde ninguno de los estudiantes debe responder todas las preguntas de la prueba.

Adicionalmente, los hallazgos de este estudio permiten inferir que orientar el trabajo pedagógico a partir de un análisis de los resultados obtenidos por SEPA en términos del logro y progreso del aprendizaje en los niveles previos a los evaluados a nivel nacional puede tener una incidencia positiva en el aprendizaje y, por lo tanto, en los resultados de SIMCE en esas generaciones de estudiantes.

Referencias

Abarzúa, A., & Contreras, J. (2019). Sistema de Evaluación de Progreso del Aprendizaje, SEPA: evidencia de su confiabilidad y validez. En J. Manzi, M. García & S. Taut (Eds.), Validez de evaluaciones educacionales en Chile y Latinoamérica (pp. 127–156). Ediciones UC.

American Educational Research Association (AERA), American Psychological Association (APA), & National Council on Measurement in Education (NCME). (2018). Estándares para pruebas educativas y psicológicas (2018 ed.). American Educational Research Association.